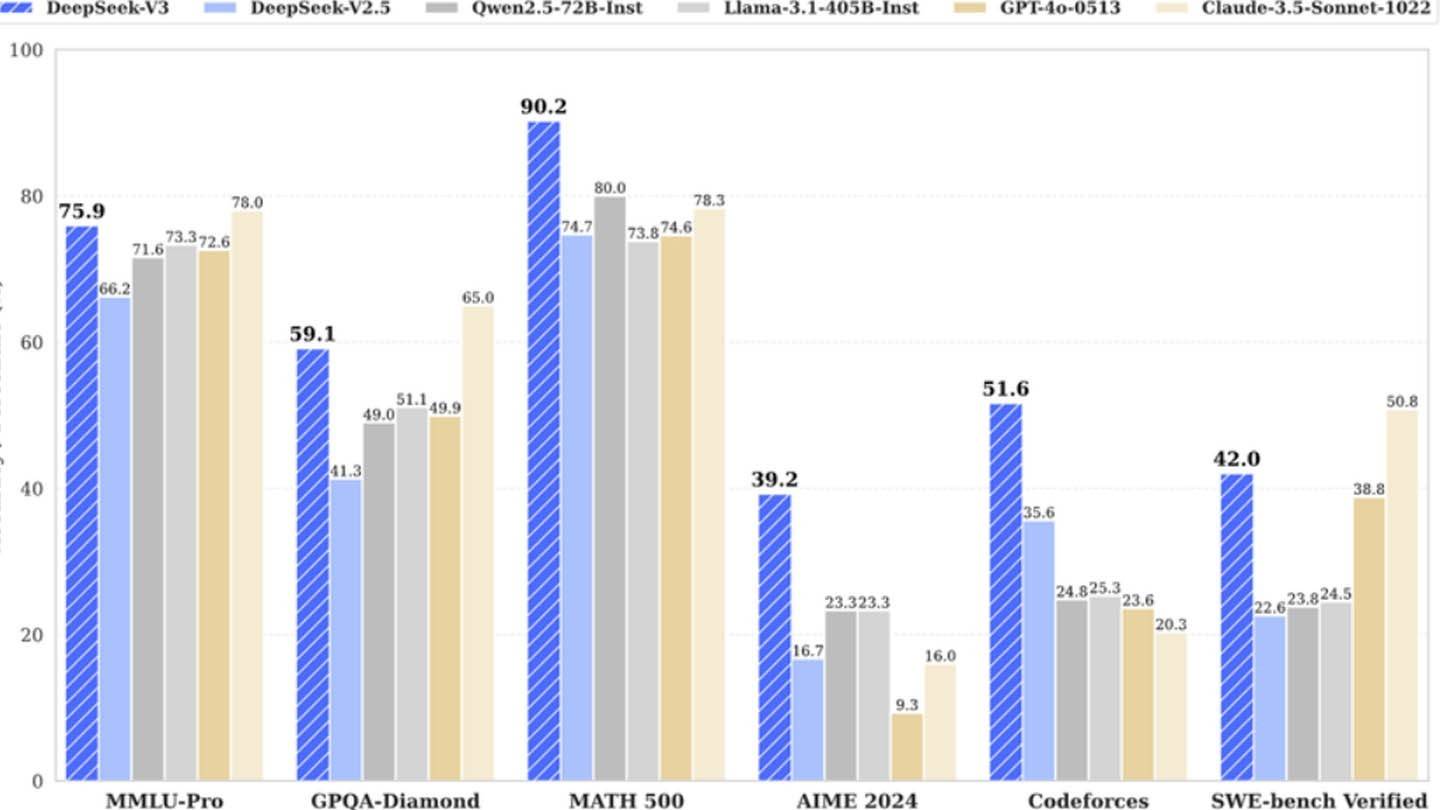

Deepseekの新しいチャットボットには、印象的な紹介があります。中国のスタートアップDeepseekの製品であるこのAIは、すぐに主要なプレーヤーになり、Nvidiaの株価の大幅な低下に貢献しています。その成功は、建築革新とトレーニング方法論のユニークな組み合わせに由来しています。

Deepseekのモデルは、いくつかの重要な技術的進歩を通じてそれ自体を区別します。

- マルチトークン予測(MTP):従来の単語ごとの予測とは異なり、MTPは複数の単語を同時に予測し、精度と効率の両方を高めます。

- 専門家(MOE)の混合:このアーキテクチャは、複数のニューラルネットワークを活用してデータを処理し、トレーニングを加速し、全体的なパフォーマンスを向上させます。 Deepseek V3は256個のニューラルネットワークを利用して、トークン処理タスクごとに8個をアクティブにします。

- マルチヘッド潜在的注意(MLA):このメカニズムは、最も重要な文要素に焦点を当てており、情報の損失を最小限に抑え、入力データの微妙な理解を確保するために重要な詳細を繰り返し抽出します。

画像:Ensigame.com

Deepseekは当初、2048 GPUのみを使用して、強力なDeepseek V3モデルに対してわずか600万ドルのトレーニングコストが非常に低いと主張しました。ただし、セミアンアリシスにより、はるかに広範なインフラストラクチャが明らかになりました。10,000H800、10,000 H100、および追加のH20ユニットを含む約50,000のNVIDIAホッパーGPUが複数のデータセンターに広がっています。これは、サーバーの総投資額を約16億ドルで、運用費用は9億4,400万ドルと推定されています。

画像:Ensigame.com

中国のヘッジファンド高飛行者の子会社であるDeepseekは、データセンターを所有しており、モデルの最適化とより高速なイノベーションの実装を比類のない管理を提供しています。その自己資金による性質は、敏ility性と意思決定を強化します。同社はまた、トップの才能を引き付け、一部の研究者は年間130万ドル以上を稼ぎ、主に中国の大学から採用しています。

画像:Ensigame.com

DeepSeekの最初の600万ドルのトレーニングコスト請求は誤解を招くように思われますが(調査、洗練、データ処理、インフラストラクチャを除いて、トレーニング前のみをカバーしています)、同社はAI開発に5億ドル以上を投資しています。その無駄のない構造は、より多くの官僚的企業と比較して、効率的なイノベーションを可能にします。

画像:Ensigame.com

Deepseekのストーリーは、資金提供された独立したAI企業が業界の巨人と競争する可能性を強調しています。しかし、その成功は、大規模な投資、技術のブレークスルー、および強力なチームに紛れもなくリンクされています。革新的な予算効率の主張は間違いなく誇張されていますが、同社のコストは競合他社よりもかなり低いままです。たとえば、DeepseekはR1に500万ドルを費やしましたが、ChatGpt4の費用は1億ドルでした。ただし、競合他社よりも安いです。

家

家  ナビゲーション

ナビゲーション

最新記事

最新記事

最新のゲーム

最新のゲーム